आर्टिफिशल इंटेलिजन्सचा वापर करून डीपफेक व्हिडीओ बनवण्याचे पेव, केजरीवाल आणि ओबामा ठरले बळी

नवी दिल्ली- आजकाल सोशल मीडियाचा वापर मोठ्या प्रमाणात वाढला आहे. कोणतीही बातमी सोशल मीडियाच्या माध्यमातून जगभरात लगेचच पोहोचते. परंतु या सोशल मीडियाचा दुरुपयोग होत असल्याचीही अनेक प्रकरणं समोर आली आहे. आता आर्टिफिशल इंटेलिजन्सचा वापर करून फेक व्हिडीओ तयार करण्याचे पेव फुटले आहेत. गेल्या काही दिवसांपूर्वी अमेरिकेतही आर्टिफिशल इंटेलिजन्सचा वापर करून डीपफेक व्हिडीओ बनवण्यात आला होता. तो व्हिडीओसुद्धा सोशल मीडियावर व्हायरल झाला होता. त्या व्हिडीओमध्ये बराक ओबामा हे अमेरिकेचे राष्ट्राध्यक्ष डोनाल्ड ट्रम्प यांच्याबाबत अपशब्द वापरत असल्याचं दाखवण्यात आलं होतं. मात्र ओबामा यांनी असं कोणत्याही प्रकारचं आक्षेपार्ह विधान केलेलं नव्हतं. आर्टिफिशल इंटेलिजन्सचा वापर करून तो व्हिडीओ तयार करण्यात आला होता. त्या व्हिडीओमध्ये बराक ओबामांसारखा हुबेहूब व्यक्ती दाखवण्यात आला होता आणि तो एक डीपफेक व्हिडीओ होता.

विशेष म्हणजे भारतीय राजकारणीही विरोधकांच्या बदनामीसाठी या डीपफेक पद्धतीद्वारे व्हिडीओ बनवण्याच्या तयारीत असल्याची माहिती समोर आली आहे. या व्हिडीओमध्ये एखाद्याचा चेहरा अशा प्रकारे बदलण्यात येतो की, पाहणा-यास तो खराच वाटेल. जॉर्डनं पिले यांनी बजफीडबरोबर मिळून जनजागृती करण्यासाठी अशा प्रकारचा व्हिडीओ बनवला होता. या व्हिडीओच्या माध्यमातून सोशल मीडियावरच्या कोणत्याही गोष्टीवर लगेचच विश्वास ठेवू नका, असा संदेश पिले यांना द्यायचा होता.

मशीन लर्निंग स्टार्टअप, लोकी टेक्नॉलॉजीच्या ऋषभ श्रीवास्तव म्हणतात, डिजिटल फसवणूक ही काही नवी गोष्ट नाही. आम्हाला माहीत आहे की, फोटोसोबत छेडछाड केली जाऊ शकते. व्हिडीओला एडिट करता येते. चेहरा बदलण्याची पद्धतही नवी नाही. परंतु आता याचा सर्रास वापर करण्यात येतो आहे आणि ते टूल्स ब-याचशा लोकांना वापरता येतेय. सायबर सिक्युरिटीतज्ज्ञ आकाश महाजन यांच्या मते, सद्यस्थितीतील यंत्रणा अशा फसवणूक करणा-यांना पकडण्यास सक्षम नाही. फॉरेन्सिक तज्ज्ञांना ऑडियोतील दोष आणि व्हिज्युअलमधील कमतरता पकडण्यासाठी ब-याच अडचणींचा सामना करावा लागतो. फसवणूक करणा-यांना पकडण्यासाठी वापरण्यात येणारं होक्सालेयर्स आणि फॅक्ट चेकर्स मदतगार नाही. फेकएप सारख्या टूल्सनं डीपफेक्स व्हिडीओ बनवण्याची पद्धत सोपी केली आहे. आता काही तासांत असं करता येणं शक्य आहे. त्यामुळेच आर्टिफिशल इंटेलिजन्स पॉर्नचा सुळसुळाट आहे. एका सेलिब्रिटीचा चेहरा दुस-याच्या शरीरावर लावून त्यांचे हावभाव खरे असल्याचंही एका यूझर्सनं डीपफेक व्हिडीओच्या माध्यमातून दाखवलं आहे. प्रियंका चोप्रासारख्या बॉलिवूड अभिनेत्रीचाही डीपफेक व्हिडीओ तयार करण्यात आला होता.

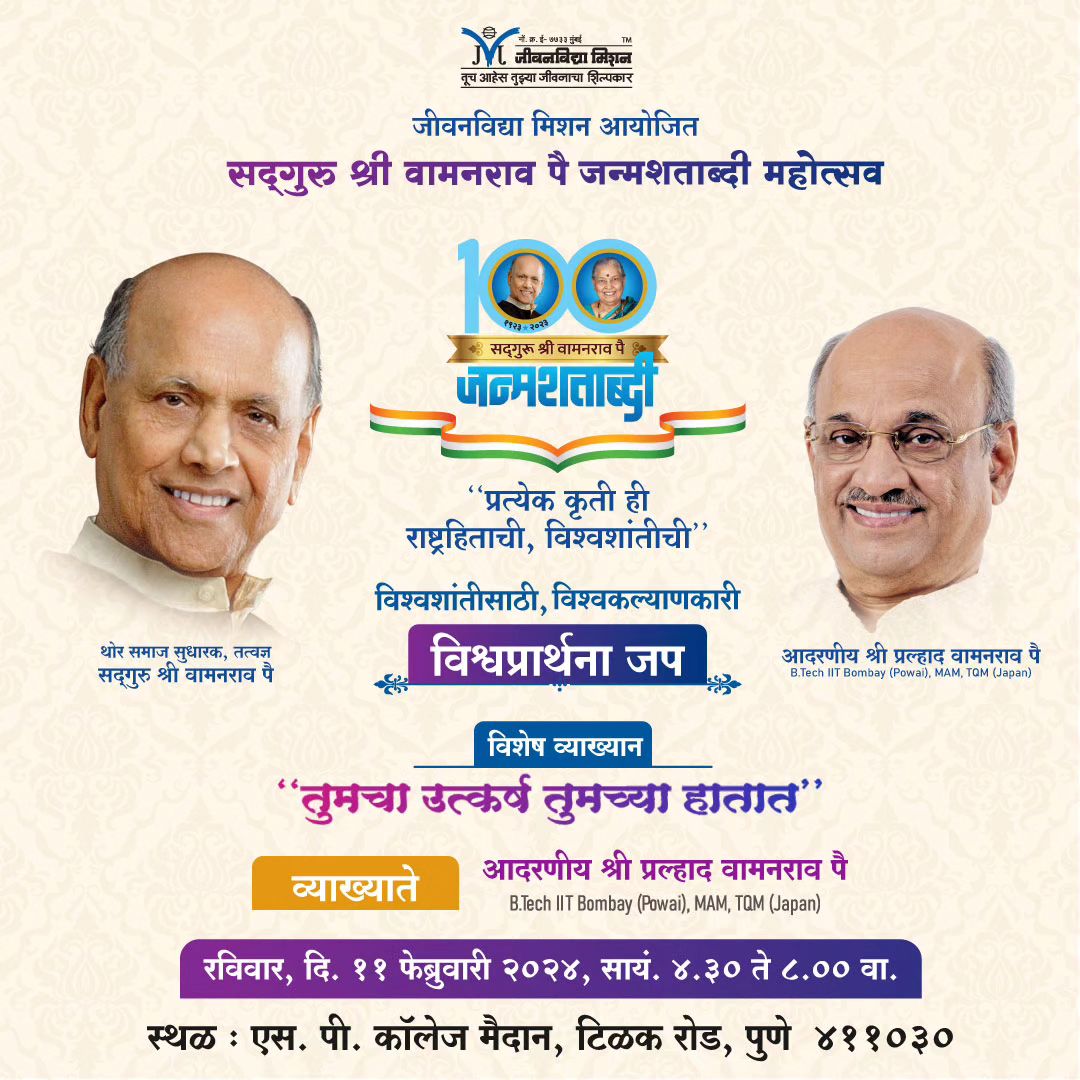

तसेच गेल्या काही दिवसांपूर्वी पंजाब निवडणुकीदरम्यान अरविंद केजरीवालांचं कथित स्वरूपातील भाषण समोर आलं होतं. ज्यात त्यांनी लोकांना काँग्रेसला मत देण्याचं आवाहन केलं होतं. तो व्हिडीओही अशाच प्रकारे बनवण्यात आल्याची शक्यता नाकारता येत नाही. यावर आम आदमी पार्टीचे सोशल मीडिया प्रमुखांनीही प्रतिक्रिया दिली आहे. आम्ही डीपफेक व्हिडीओच्या धोक्यापासून सतर्क आहोत. परंतु मीडिया आणि सामान्य जनता सतर्क नाही. त्यामुळे अरविंद केजरीवालांचा कोणीही डीपफेक व्हिडीओ बनवून तो सोशल मीडियावर व्हायरल करू शकतं.